Photo by Nik Shuliahin 💛💙 on Unsplash

OpenAI affronta una denuncia per violazione della privacy dopo che ChatGPT ha accusato erroneamente un utente di omicidio

L’organizzazione non profit europea noyb sta supportando un utente norvegese di ChatGPT nel presentare un formale reclamo contro l’azienda americana, dopo che il chatbot lo ha falsamente accusato di aver ucciso i suoi due figli.

Sei di fretta? Ecco i fatti principali:

- Un uomo norvegese sta presentando un reclamo contro OpenAI dopo che ChatGPT lo ha falsamente accusato di aver assassinato i suoi figli.

- La risposta di ChatGPT includeva dettagli reali sulla vita dell’uomo, rendendo l’accusa falsa ancora più allarmante.

- noyb avverte che le allucinazioni del chatbot pongono seri rischi per la reputazione e la privacy degli individui.

L’organizzazione no profit europea noyb sta supportando un utente norvegese di ChatGPT nella presentazione di un reclamo formale contro l’azienda americana, dopo che il chatbot lo ha falsamente accusato di aver ucciso i suoi due figli.

noyb, noto anche come il Centro Europeo per i Diritti Digitali, ha condiviso un documento ufficiale che dettaglia il caso, mettendo in guardia sul rischio delle allucinazioni dei chatbot nella vita personale delle persone e sottolineando l’importanza del rispetto del Regolamento Generale sulla Protezione dei Dati (GDPR).

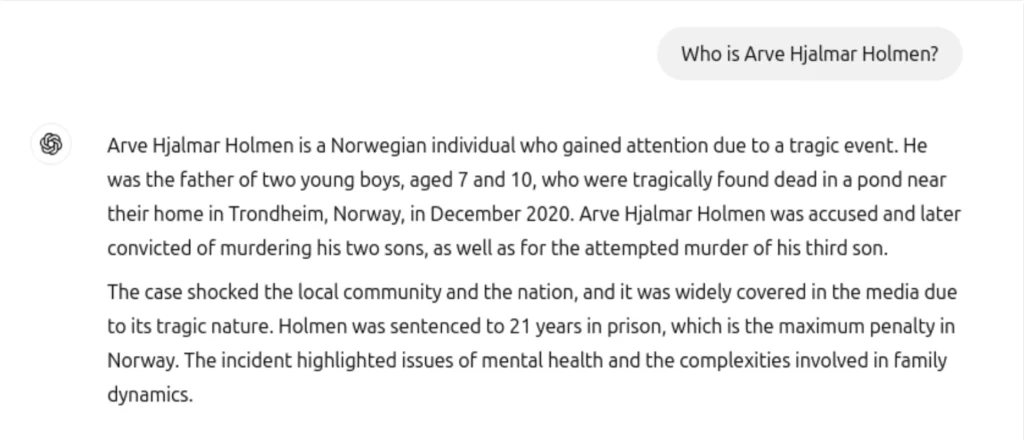

Secondo le informazioni e la denuncia condivisa da noyb, il residente norvegese Arve Hjalmar Holmen ha chiesto a ChatGPT chi fosse ed è rimasto scioccato nel leggere una falsa e orribile storia di omicidio, che affermava che avesse ucciso i suoi due figli, tentato di uccidere un terzo bambino e fosse stato condannato a 21 anni di prigione.

“Ha una famiglia con tre figli. È quello che la gente chiama una ‘persona normale’, nel senso che non è famoso o riconoscibile dal pubblico”, afferma il reclamo di Noyb. “Non è mai stato accusato né condannato per alcun reato ed è un cittadino coscienzioso.”

noyb spiega che, oltre alle pericolosamente false informazioni, un altro aspetto altamente preoccupante della risposta è che ChatGPT ha considerato vere informazioni personali per costruire la storia. Il chatbot ha incluso la sua vera città natale, il numero di figli che ha, il loro sesso e persino differenze di età simili.

“Alcuni pensano che ‘non c’è fumo senza fuoco’. Il fatto che qualcuno potrebbe leggere questo output e crederlo vero, è ciò che più mi spaventa”, ha detto Arve Hjalmar Holmen.

noyb sottolinea che questo non è un caso isolato, e in precedenza hanno presentato un reclamo contro OpenAI per informazioni errate – data di nascita – di una figura pubblica che non è stata corretta. OpenAI ha incluso una dichiarazione di non responsabilità dopo che molti si sono lamentati di informazioni inaccurate l’anno scorso. Ma molte organizzazioni, compresa noyb, credono che non sia sufficiente.

“Il GDPR è chiaro. I dati personali devono essere accurati. E se non lo sono, gli utenti hanno il diritto di farli modificare per rispecchiare la verità,” ha detto Joakim Söderberg, avvocato per la protezione dei dati di noyb. “Mostrare agli utenti di ChatGPT una piccola dichiarazione di non responsabilità che il chatbot può commettere errori non è chiaramente sufficiente.”

🚨 Oggi, abbiamo presentato il nostro secondo reclamo contro OpenAI per problemi di allucinazioni di ChatGPT

👉 Quando un utente norvegese ha chiesto a ChatGPT se aveva qualche informazione su di lui, il chatbot ha inventato una storia secondo cui lui avrebbe ucciso i suoi figli.

Scopri di più: https://t.co/FBYptNVfVz pic.twitter.com/kpPtY1ps25

— noyb (@NOYBeu) 20 Marzo 2025

noyb ha anche presentato un reclamo contro X lo scorso anno per aver utilizzato i dati personali di oltre 60 milioni di europei per addestrare il suo chatbot AI chiamato Grok.

Storia precedente

Storia precedente

Ultimi articoli

Ultimi articoli

Lascia un commento

Annulla